近日,东北大学机器人科学与工程学院机器人认知实验室(Robot Cognition Lab,RCL)的最新研究成果“Evaluating the Long-Term Memory of Large Language Models”被自然语言处理顶级会议ACL 2025(CCF A类)接收。东北大学贾子熙副教授为论文第一作者兼通讯作者,2023级硕士刘清华为第二作者,东北大学为第一完成单位。

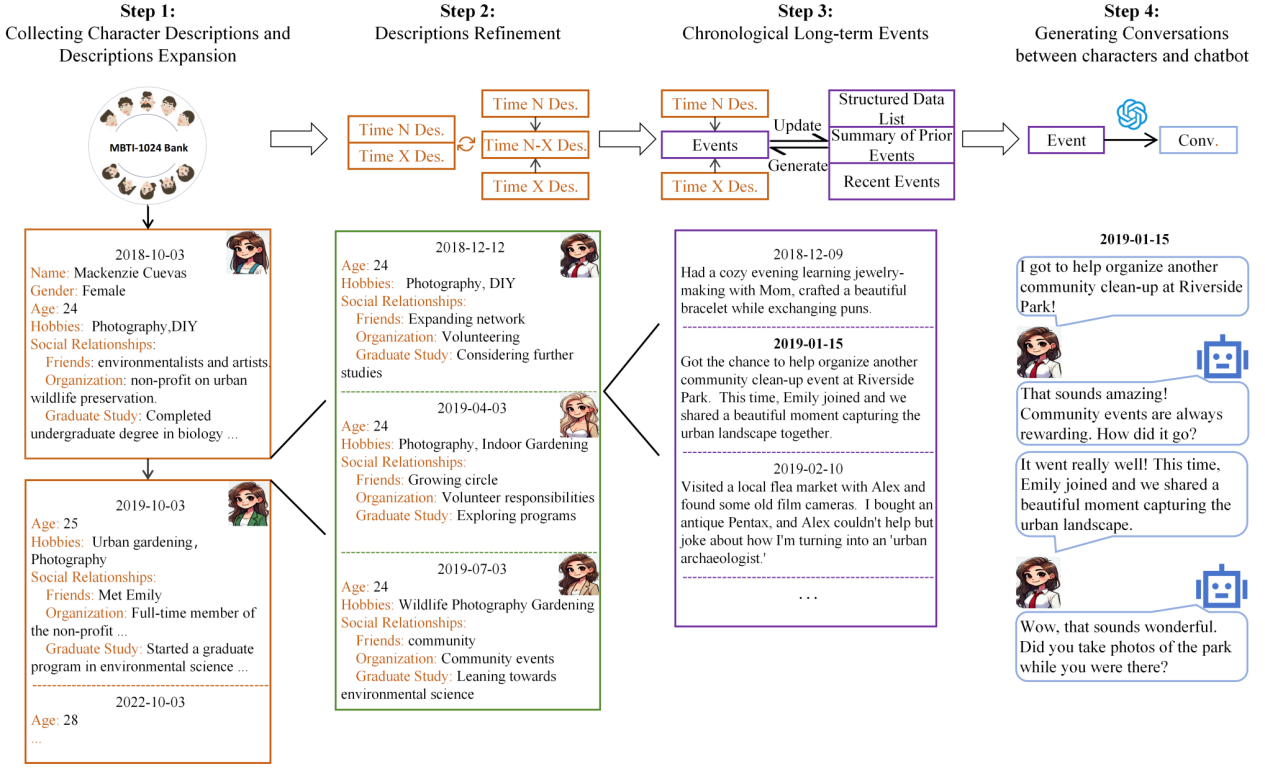

虽然大模型的应用日益广泛,可人们对其原理又知之有限。RCL团队为了探究大模型的记忆规律,创新性地构建了超长对话数据集,如图1所示,模拟人类长期聊天的内容和过程,并以此针对主流大模型进行了长期记忆能力评估。该团队惊喜地发现,大模型展现出与人类相似的记忆特性:记忆会随时间推移逐渐衰减;对不同类型信息存在记忆偏好(如对地点、名称的保留强于事件细节);间隔式重复训练(Spaced Rehearsal)比集中式训练能更有效地增强记忆的持久性。该团队的工作为进一步研究大模型的结构与原理提供了一种新思路。

图1超长期对话数据集构造流程